Privacyzorgen over Big Data bij opsporing

- 05 mei 2016

Hoe kan Big Data gebruikt worden voor een effectiever veiligheidsbeleid zonder dat daarbij de privacywaarborgen verloren gaan? Hoe kunnen we straks genieten van de voordelen zonder de nadelen te ervaren? Vragen die ons bezighouden, en vragen die de regering stelde aan de Wetenschappelijke Raad voor het Regeringsbeleid (WRR). Hier volgen de belangrijkste conclusies en aanbevelingen van de WRR.

Wat is Big Data eigenlijk?

Het rapport Big data in een vrije en veilige samenleving van de WRR geeft geen definitie van Big Data maar beschrijft een drietal hoofdkenmerken om duidelijk te maken waar het bij Big Data om gaat:

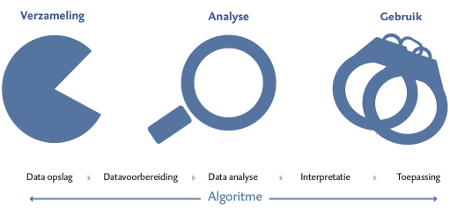

- Data: het gaat om grote hoeveelheden gestructureerde en ongestructureerde data uit verschillende bronnen.

- Analyse: de analyse is ‘data-driven’ en zoekt geautomatiseerd naar correlaties. De grootste potentie wordt verwacht van realtime en voorspellende analyses.

- Gebruik: de analyses moeten leiden to ‘actionable knowledge’ (ingrepen in de realiteit op basis van bestandsanalyses.

Dit zijn meteen ook de drie fasen van een standaard Big Data toepassing: eerst gegevens verzamelen, ze vervolgens analyseren en er dan iets zinnigs mee proberen te doen.

Wordt Big Data al gebruikt in het veiligheidsdomein?

De Raad heeft zeven verschillende cases van datagebruik binnen het veiligheidsdomein goed bekeken. Van het Criminaliteits Anticipatie Systeem (CAS) van de Amsterdamse politie (vorig jaar nog goed voor een Big Brother Award) tot de Infobox Crimineel Onverklaarbaar Vermogen, en van de analysetechnieken van de Belastingdienst (zie ook dit stuk van Maurits Martijn) tot aan het controversiële Systeem Risico Indicatie (SYRI). Ook Smart Borders en Smart Cities komen natuurlijk aan bod.

De auteurs merken op dat in die cases Big Data vaak nog maar een beperkte rol speelt. Er wordt bijvoorbeeld nog amper gebruik gemaakt van datagestuurde analyses en in plaats van effectievere opsporing gaat het vaak gewoon om automatisering waardoor standaard processen goedkoper gedaan kunnen worden. Wel wordt er al verschrikkelijk veel data aan elkaar gekoppeld.

Is Big Data wel effectief?

De potentiële voordelen van Big Data liggen volgens het rapport op het gebied van efficiëntie, het terugkijken in de geschiedenis, het real-time analyseren en op het voorspellen van misdaad.

Daar staan een aantal potentiële problemen tegenover. De analyse van data is volgens de Raad bijvoorbeeld nooit neutraal omdat het theoretisch kader altijd vooronderstellingen bevat. Verder kun je uit correlatie geen causaliteit afleiden en ontkom je er niet aan dat er in Big Data-analyses altijd fouten zullen zitten. En als je gaat zoeken in grote hoeveelheden data vind je altijd wel correlaties, maar of die ook betekenisvol zijn weet je niet.

Omdat Big Data gebaseerd is op patroonherkenning in grote hoeveelheden data is het eigenlijk alleen maar geschikt voor veiligheidsvraagstukken die een regelmatig karakter hebben. Als een vraagstuk heel weinig voorkomt (denk aan terreur) dan is er onvoldoende materiaal beschikbaar om een betekenisvol patroon te ontdekken. Het rapport is daarmee (impliciet) bijzonder kritisch over de te verwachten effectiviteit van de plannen van Plasterk voor een sleepnet voor de geheime diensten:

“Datamining – de voor Big Data kenmerkende analysevorm – is niet voor alle vormen van misdaadbestrijding even geschikt. Datamining is voor het voorkomen van terroristische aanslagen waarschijnlijk een ineffectieve methode. Patroonherkenning werkt het beste bij overtredingen die een vast en terugkerend patroon laten zien. Omdat elke terroristische aanslag uniek is, is het nagenoeg onmogelijk om een goed profiel te maken. In combinatie met een gering aantal aanslagen levert dit te hoge foutpercentages op.”

Wat zijn de risico’s van Big Data?

De WRR staat ook stil bij de grote risico’s van het gebruik van Big Data. Zo leiden data-gedreven oplossingen altijd tot social sorting en liggen daarbij discriminatie en profilering op de loer. Het is bijna per definitie onmogelijk om privacy en Big Data met elkaar te rijmen. Het gaat bij Big Data vaak om miljoenen kleine individuele privacyschendingen (zo klein dat mensen zelden naar de rechter stappen) die samen, bij elkaar opgeteld, wel degelijk een grote schending zijn. Verder is er altijd een kans op function creep: het inzetten van de data of methodologie van één succesvol Big Data project in een ander project met een andere context. Ook is er het gevaar van een chilling effect (met alle negatieve gevolgen voor de democratie van dien) als mensen zich anders gaan gedragen doordat de overheid private data voor veiligheidsdoeleinden gaat gebruiken. Tot slot uiten de auteurs hun zorgen over de informatieongelijkheid die in de hand wordt gewerkt door Big Data. Ze benoemen daarbij de transparantieparadox: het feit dat burgers steeds transparanter worden voor de overheid en bedrijfsleven, terwijl deze organisaties in de manier waarop ze de data in hun analyses gebruiken niet open zijn naar burgers.

Een horizonbepaling, beter toezicht en de menselijke maat

Big Data is volgens de Raad niet meer te stoppen. We moeten dus nadenken over hoe we de risico’s kunnen inperken. Het rapport komt daarvoor met een aantal aanbevelingen. Zo zou er rondom het gebruik van Big Data een wettelijk te omschrijven zorgplicht moeten gaan gelden en moeten Big Data projecten door een externe toezichthouder worden ge-reviewed waarbij die toezichthouder ook meteen moet controleren of aan de zorgplicht wordt voldaan. Daarnaast moeten grote dataverwerkingsprojecten binnen de overheid (en in het veiligheidsdomein) een horizon van 3 tot 5 jaar krijgen: als het project niet blijkt te werken, dan moet het weer worden opgedoekt. Ook wordt er aanbevolen om geautomiseerde beslissingen (“computer says no“) te beperken en juridisch vast te leggen dat de verantwoordelijkheid voor de juistheid van een Big Data-beslissing bij de gegevensverwerker blijft. De overheid mag de computer of het algoritme dus niet de baas maken of de schuld geven.

Reguleren we het verzamelen of het gebruik van data?

Volgens de auteurs van het rapport is hun belangrijkste conclusie dat de focus van de huidige wet- en regelgeving op de fase van het verzamelen van gegevens in het Big-Data tijdperk niet meer volstaat. Hun voornaamste aanbeveling is dan ook om het regulerend kader te verbreden van het verzamelen van gegevens naar de regulering van de analyse en het gebruik van de gegevens.

Hoewel wij het een goed idee vinden om de analyse en het gebruik van data beter te reguleren vinden we dat dit niet ten koste mag gaan van het reguleren van het verzamelen van de data. Anders gezegd: het beperken van hoe data gebruikt mag worden kan wat ons betreft niet als oplossing dienen voor het fundamentele probleem dat Big Data heel slecht te verenigen is met fundamentele uitgangspunten van (Europese) privacywetgeving zoals doelbinding.

In een artikel in de verkenning Exploring the Boundaries of Big Data, die tegelijkertijd met het rapport is uitgekomen, schrijft Joris van Hoboken (naast academicus ook voorzitter van Bits of Freedom) over deze spanning:

The most productive way to address this tension would be to see use-based regulation not as an alternative to regulation of collection, but as a complimentary regulatory strategy that can help address some of the new challenges to privacy inherent in the possibilities of large-scale data analytics.

Naar onze smaak hebben de auteurs van het rapport te weinig naar deze suggestie geluisterd en blijven ze te ambivalent over dit punt. Zo staat er in de factsheet met aanbevelingen dat “de aandacht moet worden verlegd van het reguleren van het verzamelen van data [..] naar de regulering van [..] de fases van de analyse en het gebruik van Big Data.” Die aandacht verleggen lijkt ons geen goed idee, juist niet binnen het veiligheidsdomein. Het is essentieel om zowel het gebruik als het verzamelen te reguleren.

Verder praten met de minister

Toen wij de net aangetreden minister van Veiligheid en Justitie naar een visie op privacy vroegen kregen wij van hem de verzekering dat hij ons (en de rest van de ‘Privacycoalitie’) daarbij zou betrekken. In zijn toespraak bij het in ontvangst nemen van het rapport deed hij deze belofte nogmaals. Wij kijken er dus naar uit om betrokken te worden.

Meer lezen?

Op de website van de WRR vind je meer informatie. Je kunt een aantal zaken ook direct als PDF downloaden: de factsheet met aanbevelingen, de samenvatting, het volledige rapport en tot slot de bijbehorende wetenschappelijke verkenning.

Wat vind jij?

Bits of Freedom vind het goed om te lezen dat de wetenschappelijke adviseurs van de regering zo kritisch zijn op de rol van big data in een vrije en veilige samenleving. Wat vind jij? Kan Big Data ons helpen bij een effectievere opsporing zonder dat dit ten koste gaat van privacy? En wat vind je van de discussie over verzamelen versus gebruik? Laat het ons en de WRR weten.